Когда Рейс 4U9525 Germanwings врезался во французские Альпы в марте 2015, следователи довольно быстро определили вероятную причину катастрофы: второй пилот Андреас Любиц (Andreas Lubitz) страдал от депрессии и решил совершить самоубийство, прихватив с собой более 100 пассажиров. Почему ему разрешили пилотировать самолет с множеством пассажиров на борту, несмотря на психическое заболевание? Как ему удалось закрыться одному в кабине пилота? По каким показателям был сделан вывод, что все произошло именно так?

Данный перечень вопросов стал стандартным во всех следующих авариях — они дают понять, что в любой сложной технической системе человек хоть и важная, но лишь составная часть огромного механизма. Чаще всего, если специалисты не могут выявить механическую причину аварии, они называют человеческий фактор как решающий элемент катастрофы, но всем известно, что ошибки редко происходят в вакууме.

Кто же виноват?

Ранее понятие «человеческий фактор» не существовало, однако с появлением сложных технологий оно стало играть все более значительную роль. Конечно, наши предки допускали ошибки, но те не оказывали такого огромного влияния на жизни других людей. Все изменилось с промышленной революцией: с приходом новых технологий рабочий стал своего рода «винтиком» на фабрике. Под давлением повторяющихся задач несчастные случаи стали настолько распространены, что порой приходилось закрывать поточное производство. Вместо поиска дефектов в своем оборудовании владельцы фабрик обвиняли во всем «человеческий фактор». К началу 20-го века психологи изучали так называемых «невезучих» сотрудников и задавались вопросом, почему они сделали именно так, а не иначе.

Представление о «человеческом факторе» существенно изменилось во время Второй мировой войны, когда новые технологии появлялись настолько стремительно, что мог ошибиться даже самый умелый человек. В 1943 американские Военно-воздушные силы, во главе с психологом Альфонсе Чапэнисе (Alphonse Chapanis), были призваны исследовать причину повторного допущения ошибок на одном и том же самолете: после, казалось бы, удачного приземления, пилоты забывали включить шасси, что неминуемо приводило к искрам и воспламенению летательного аппарата. Чапэнис заметил, что на B-17 два рычага, управляющие шасси и закрылками, идентичны и помещены рядом друг с другом. Обычно пилот выпускает шасси и затем поднимает закрылки, действующие как пневматические тормоза и ставящие самолет на колеса. Но в хаосе военного времени пилот мог легко перепутать рычаги-близнецы и вместо шасси задействовать закрылки. Чапэнис предложил присоединить резиновое колечко к рычагу шасси и сделать клинообразным рычаг, отвечающий за закрылки — так пилоты могли сразу почувствовать, какой рычаг они используют, что и решило проблему. Таким образом стало ясно, что проблемой был не пилот, а неудачно спроектированная панель управления.

B-17 после неудачной посадки с убранным шасси

После войны специалисты обратили пристальное внимание на исследование «человеческих факторов» — теперь основная задача состояла не «свалить» всю вину на людей, а найти причину в самой системе. В 1967 был создан Национальный совет по безопасности для выявления такого рода ошибок путем проведения технического и процедурного анализа, благодаря чему коммерческие перелеты стали одним из самых безопасных видов транспорта.

«Нормальный несчастный случай»

Эксперты выяснили, что полностью от всех несчастных случаев избавиться невозможно: проблема заключается не только в технологии, приводящей к «человеческой ошибке», но и в культуре, в которой технология работает. В связи с частичным крахом ядерного реактора Three Mile Island, социолог Чарльз Перроу (Charles Perrow) разработал теорию «нормального несчастного случая», идея которой в том, что некоторые технологии настолько сложны, что несчастные случаи неизбежно будут происходить.

После катастрофы шаттла Challenger социолог Дайан Вон (Diane Vaughan) опубликовала теорию «нормализованного отклонения» (normalized deviance) — NASA настолько привыкли к дефекту в кольцевых уплотнителях, препятствовавших выходу легковоспламеняющегося газа, что бедствие, вызванное теми же дефектами, стало для них неожиданностью.

Важно помнить, что простое нахождение «козла отпущения» никак не поможет исправить дефекты в системе. По этой причине подход, названный анализом первопричины (root-cause analysis), стал использоваться и в промышленности, и в пожаротушении, и медицине. Несколько десятилетий назад анестезия была одной из самых опасных медицинских процедур. Во время исследования проблемы эксперты узнали, что они могли спасти жизни при правильно настроенном оборудовании. После настройки число несчастных случаев резко снизилось в 50 раз по сравнению с предыдущим опытом. Некоторые хирурги перед операцией должны пройти чек-лист, подобно пилотам.

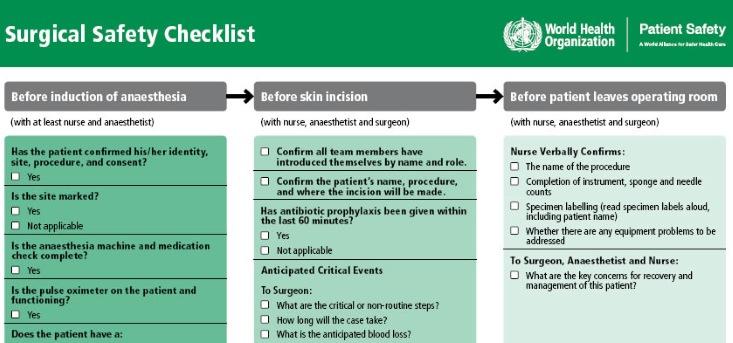

Часть хирургического контрольного списка World Health Organization:

До ввода амнезии: Подтвердил ли пациент свою личность и дал ли согласие? Готово ли место? Была ли произведена проверка лекарств и анестезирующего оборудования? Правильно ли настроен оксиметр?

До разрезания кожи: Убедиться, что все члены команды представились по фамилии и назвали свою роль. Проверить имя пациента, его согласие на операцию и на место разреза. Была ли проведена профилактика антибиотиком за последние 60 минут? Описать возможные нестандартные ситуации. Как долго продлится операция? Какова ожидаемая потеря крови?

До того, как пациент покинет операционную: Убедиться, что выполнена требуемая операция. Убедиться в наличии всех губок и иголок. Громко и четко назвать всех участников операции, в том числе имя пациента. Убедиться, что оборудование функционирует верно. Сообщить, что лучше делать клиенту для скорейшей поправки.

Система правосудия

Сложнее всего дела обстоят с анализом системы правосудия. Психологи и судебные эксперты пришли к выводу, что причины юридических проблем лежат глубже фанатичного обвинителя или дезинформированного полицейского — здесь также имеет место череда обстоятельств. Рассмотрим печально известную стрельбу Майкла Брауна (Michael Brown) в Фергюсоне, Миссури. Никто не предполагал, что чиновник Даррен Уилсон (Darren Wilson) после утреннего пробуждения решит застрелить невооруженного подростка. Стоит задаться вопросами: был ли он вооружен не летальным оружием? Был ли его партнер в полицейской машине? В какой степени имел место расизм?

Джеймс Дойл (James Doyle), выдающийся адвокат, выступающий за системный анализ в полицейского и судебного управления, говорит: «Нельзя прощать людей, вроде Уилсона или Любица, но нужно всегда искать причину, беря во внимание тот факт, что мы все живем в социальных сетях и в мире сложных технологических систем».

Высоких вам конверсий!

По материалам: nautil.usimage source shamshel